链接:https://www.zhihu.com/question/377225514/answer/1892158884191393735

来源:知乎

著作权归作者所有。商业转载请联系作者获得授权,非商业转载请注明出处。

安装规划

系统安装

下载最新版本:官方下载链接 https://enterprise.proxmox.com/iso/proxmox-ve_8.3-1.iso

使用 U 盘安装,安装方法参考:新一代多系统启动U盘解决方案 Ventoy

网络规划

enp1s0f0 enp1s0f1: 千兆/万兆接口, 交换机配置 Access 模式

enp129s0f0 enp129s0f1: 万兆接口, 交换机配置 Trunk 模式

bond0: Linux Bond(mode6), Slaves: enp1s0f0 enp1s0f1, 作为管理网络

bond1: Linux Bond (mode4/mode6), Slaves: enp129s0f0 enp129s0f1, 作为数据网络

bond1.X: Linux VLAN, VLAN tag: X (vlan_id), 其中 bond1.11 作为迁移网络, bond1.12 作为存储网络, bond1.X 作为桥接网络 (供虚拟机使用)

vmbrX: Linux Bridge, 作为虚拟机业务网络

以下是一个配置好的示例

# cat /etc/network/interfaces

auto lo

iface lo inet loopback

auto enp1s0f0

iface enp1s0f0 inet manual

auto enp1s0f1

iface enp1s0f1 inet manual

auto enp129s0f0

iface enp129s0f0 inet manual

auto enp129s0f1

iface enp129s0f1 inet manual

auto bond0

iface bond0 inet static

address 192.168.100.4/24

gateway 192.168.100.254

bond-slaves enp1s0f0 enp1s0f1

bond-miimon 100

bond-mode balance-tlb

#管理网络

auto bond1

iface bond1 inet manual

bond-slaves enp129s0f0 enp129s0f1

bond-miimon 100

bond-mode balance-tlb

auto bond1.10

iface bond1.10 inet static

address 172.16.10.4/24

#迁移网络

auto bond1.11

iface bond1.11 inet static

address 172.16.11.4/24

#存储网络

auto bond1.101

iface bond1.101 inet manual

auto bond1.102

iface bond1.102 inet manual

auto bond1.103

iface bond1.103 inet manual

auto vmbr101

iface vmbr101 inet manual

bridge-ports bond1.101

bridge-stp off

bridge-fd 0

#生产环境

auto vmbr102

iface vmbr102 inet manual

bridge-ports bond1.102

bridge-stp off

bridge-fd 0

#演示环境

auto vmbr103

iface vmbr103 inet manual

bridge-ports bond1.103

bridge-stp off

bridge-fd 0

#开发环境更新配置

软件源更换

非订阅用户可以将软件源更换为国内镜像源

# mv /etc/apt/sources.list.d/pve-enterprise.list /etc/apt/sources.list.d/pve-enterprise.list.bak

# cp /etc/apt/sources.list /etc/apt/sources.list.orig

# cat /etc/os-release

... 查看系统版本

# OS_VERSION=$(lsb_release -cs) && cat > /etc/apt/sources.list <<EOF

deb https://mirrors.ustc.edu.cn/debian ${OS_VERSION} main contrib non-free

deb https://mirrors.ustc.edu.cn/debian ${OS_VERSION}-updates main contrib non-free

deb https://mirrors.ustc.edu.cn/debian-security ${OS_VERSION}/updates main contrib non-free

deb http://mirrors.ustc.edu.cn/proxmox/debian/pve ${OS_VERSION} pve-no-subscription

EOF软件包锁定

避免自动更新导致异常问题,如果需要升级可在测试环境验证无误后再到生产环境解除软件包锁定后再更新升级

必要的软件包

# apt install -y lshw parted kpartx ifupdown2 ethtool net-tools vim unzip

# 软件版本锁定

# dpkg --get-selections # 查看 hold 为锁定状态

# dpkg --get-selections | awk '{print $1,"hold"}' | dpkg --set-selections

# 软件版本解锁

# dpkg --get-selections | awk '{print $1,"install"}' | dpkg --set-selections

或者备份并清空软件源配置文件

# cp -rp /etc/apt/sources.list /etc/apt/sources.list.orig

# cp -rp /etc/apt/sources.list.d /etc/apt/sources.list.d.orig

# echo > /etc/apt/sources.list

# rm -f /etc/apt/sources.list.d/*必要配置

开启嵌套虚拟化

检查虚拟机是否支持虚拟化, 如果没有输出表示不支持

# egrep --color 'vmx|svm' /proc/cpuinfo

检查是否开启 nested, 如果返回 Y 表示已经开启

# cat /sys/module/kvm_intel/parameters/nested

不重启物理机, 需要先关闭所有虚拟机

# modprobe -r kvm_intel

# modprobe kvm_intel nested=1

# cat /sys/module/kvm_intel/parameters/nested

Y

配置系统启动自动开启 nested

# echo "options kvm_intel nested=1" > /etc/modprobe.d/kvm_intel.conf # Intel CPU

## echo "options kvm_amd nested=1" > /etc/modprobe.d/kvm-amd.conf # AMD CPU

虚拟机配置 host 模式

# qm set 32191 --cpu cputype=host

# qm start 32191

检查虚拟机是否支持虚拟化, 如果有输出则表示支持

vm-pve32191# egrep --color 'vmx|svm' /proc/cpuinfoCloudinit 增强

禁用新创建的主机自动更新,并允许 ssh 密码登录 (如果没有定义 ssh key 但定义了密码)

# vim +138 /usr/share/perl5/PVE/QemuServer/Cloudinit.pm

if (defined(my $keys = $conf->{sshkeys})) {

...

} elsif (defined($password)) {

$content .= "ssh_pwauth: 1\n";

}

...

$content .= "package_upgrade: false\n";

# systemctl restart pvedaemon.service公司用了一年vSphere,后来迁移到PVE。作为公司兼职网管,从使用体验上说一说二者的差别吧。

集群管理。vSphere是由独立的vCenter进行管理,虚拟机的备份迁移比较容易,虚拟交换机功能也比较强,管理规模也大。PVE的集群体验糟透了:有虚拟机不允许加集群;加了很难退出集群;加集群有概率会失败然后再加就一直失败;好不容易命令行退出集群了,发现那个节点废了只能重装;加入集群后也有一些奇怪的原因会让你的机器脱离集群变单点,然后费很大功夫各种查资料加回来,关键这货出问题的时候业务部门都在催命啊,死的心都有了。我想跟PVE的开发团队说一声求你们做个人吧。至于什么Ceph,你跟集群有毛关系啊,为什么要强迫我用,我们买不起存储还是咋地?易用性方面vSphere完胜。

硬件支持。PVE完胜。包括显卡穿透。

性能。二者差不多。

云桌面,看到别家用VMWARE Horizon那个羡慕啊,唉,都换PVE了还能说点啥的,装个水货堡垒机玩着吧。

容器,看到有人吹LXC我就好笑,虽说我是LXC的技术粉,但你用容器真的只是用个容器啊,那不是当虚拟机玩么,持续集成怎么搞?k8s不要了吗?你客户有人用LXC?而且PVE的容器经常掉IP,我家顶配Dell R740xd也有这问题,不接受硬件方面的质疑。玩了几个月LXC现在还是用回虚拟机安逸。

稳定性,老老实实用,别整幺蛾子,二者都差不多。

价格,这就是我们换PVE的原因了,说多了都是泪。

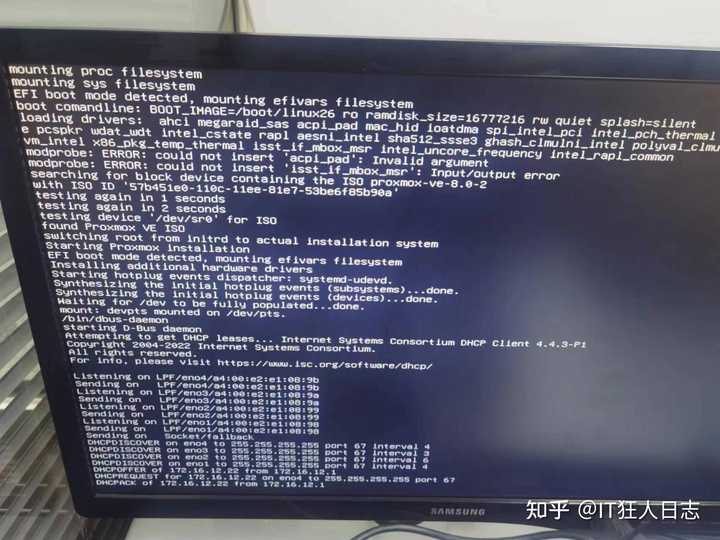

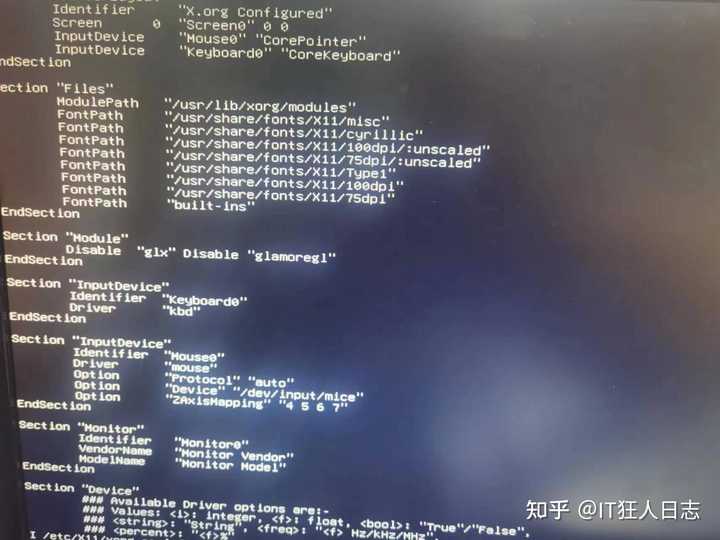

华为服务器,无法安装Proxmox VE,测试了7.4.1和8.0.2,都是各种报错。 根据查到的资料,在安装停止前或者停止后,按CTRL+ALT+F3,调出另外一个终端窗口,输入命令Xorg -configure,注意X必须大写,否则查无此命令。把生成的配置文件,移动到/etc/X11路径下,并且重命名为xorg.conf:mv xorg.conf.new /etc/X11/xorg.confVi /etc/X11/xorg.conf 修改配置文件:需要修改的有两个地方,一个是将Load “glx”替换成Disable “glx”,并在此行尾部增加文本Disable "glamoregl";

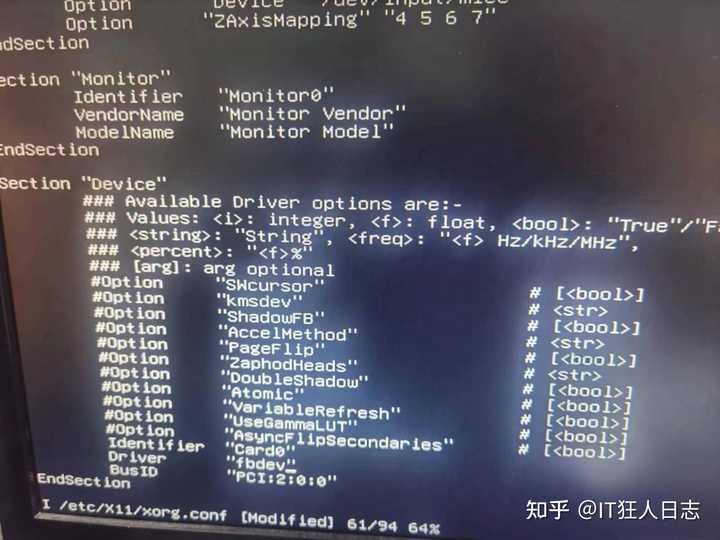

根据查到的资料,在安装停止前或者停止后,按CTRL+ALT+F3,调出另外一个终端窗口,输入命令Xorg -configure,注意X必须大写,否则查无此命令。把生成的配置文件,移动到/etc/X11路径下,并且重命名为xorg.conf:mv xorg.conf.new /etc/X11/xorg.confVi /etc/X11/xorg.conf 修改配置文件:需要修改的有两个地方,一个是将Load “glx”替换成Disable “glx”,并在此行尾部增加文本Disable "glamoregl"; 另一个是将Driver "modesetting"替换成文本Driver "fbdev"

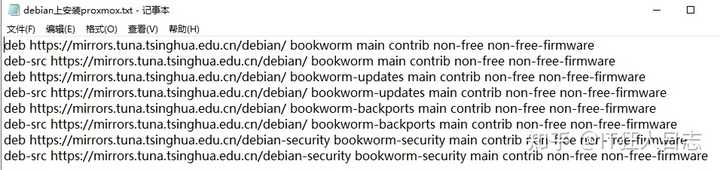

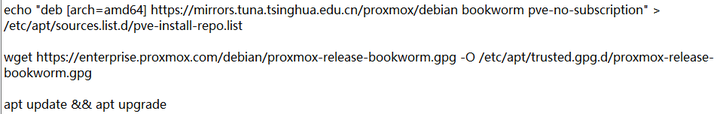

另一个是将Driver "modesetting"替换成文本Driver "fbdev" 执行指令“startx”,画面只是出现了一个箭头,并没有显示安装界面。重新来,修复完配置文件后,再次按CTRL+ALT+F3,切换终端窗口,再次执行指令“startx”,还是一样的,只显示一个鼠标箭头,画面黑屏,且无响应。无论是7.4.1还是8.0.2,都是一个样,看来这个方法从7.4.1之后就没用了,或者说手上这台华为服务器的情况不同,索性放弃直接安装Proxmox VE了。众所周知,PVE基于Debian,所以我打算先安装Debian再安装PVE。PVE 8 升级了内核,是基于Debian12的,所以直接到清华大学镜像站点下载了Debian12。登录华为iBMC,选取Debian12的ISO文件,并且设置为引导盘。Debian12安装过程略,因为就是点几个下一步,没什么好写的。安装完成后,首先切换为清华大学源:

执行指令“startx”,画面只是出现了一个箭头,并没有显示安装界面。重新来,修复完配置文件后,再次按CTRL+ALT+F3,切换终端窗口,再次执行指令“startx”,还是一样的,只显示一个鼠标箭头,画面黑屏,且无响应。无论是7.4.1还是8.0.2,都是一个样,看来这个方法从7.4.1之后就没用了,或者说手上这台华为服务器的情况不同,索性放弃直接安装Proxmox VE了。众所周知,PVE基于Debian,所以我打算先安装Debian再安装PVE。PVE 8 升级了内核,是基于Debian12的,所以直接到清华大学镜像站点下载了Debian12。登录华为iBMC,选取Debian12的ISO文件,并且设置为引导盘。Debian12安装过程略,因为就是点几个下一步,没什么好写的。安装完成后,首先切换为清华大学源: apt update && apt upgrade 更新一下。vim /etc/hosts 编辑hosts文件,准备添加条目172.16.12.2 http://pve189.hcit.cc 就是ip地址和PVE的完整名称。添加Proxmox源,将GPG密钥添加到APT源密钥环中,再次更新:

apt update && apt upgrade 更新一下。vim /etc/hosts 编辑hosts文件,准备添加条目172.16.12.2 http://pve189.hcit.cc 就是ip地址和PVE的完整名称。添加Proxmox源,将GPG密钥添加到APT源密钥环中,再次更新: 现在可以安装PVE了:apt-get install proxmox-ve postfix open-iscsi ksmtuned ceph-base -y安装完成后,remove os-prober,因为我们不需要双引导。重启服务器。重启后,屏幕就显示为PVE该有的样子了,只要自己不说,没人会认为它是在Dibian基础上安装的。当然还有最后一步,WEB登录PVE管理界面后,必须创建一个名为vmbr0的Linux Bridge,并且把网卡添加进去,设置IP地址,点击“应用”否则虚拟机就无法联网了。有多块网卡的话,建议创建bond0,以防交换机端口或者网卡故障带来中断服务的风险。

现在可以安装PVE了:apt-get install proxmox-ve postfix open-iscsi ksmtuned ceph-base -y安装完成后,remove os-prober,因为我们不需要双引导。重启服务器。重启后,屏幕就显示为PVE该有的样子了,只要自己不说,没人会认为它是在Dibian基础上安装的。当然还有最后一步,WEB登录PVE管理界面后,必须创建一个名为vmbr0的Linux Bridge,并且把网卡添加进去,设置IP地址,点击“应用”否则虚拟机就无法联网了。有多块网卡的话,建议创建bond0,以防交换机端口或者网卡故障带来中断服务的风险。

推荐本站淘宝优惠价购买喜欢的宝贝:

本文链接:https://www.hqyman.cn/post/11517.html 非本站原创文章欢迎转载,原创文章需保留本站地址!

休息一下~~

微信支付宝扫一扫,打赏作者吧~

微信支付宝扫一扫,打赏作者吧~